Intelligence Artificielle et DM : le brouillard des règles à appliquer

Formidable vecteur d'innovation, l'intelligence artificielle (IA) investit rapidement le secteur du DM, dans un environnement réglementaire pour le moins nébuleux. Un sujet sur lequel Olivier Deroo fait ici le point, après un bref rappel des concepts de base de l’IA avec apprentissage automatique.

Par Olivier Deroo, expert dispositifs médicaux chez Emitech et membre du réseau DM Experts

Par Olivier Deroo, expert dispositifs médicaux chez Emitech et membre du réseau DM Experts

Depuis plusieurs années, l’intelligence artificielle se répand rapidement dans les solutions proposées par les fabricants de dispositifs médicaux et de dispositifs de diagnostic in vitro, par exemple dans les domaines de la radiologie, de la cardiologie ou de la médecine générale.

De leur côté, les autorités de régulation et les normalisateurs peinent encore à prendre en compte tous les nouveaux dangers et toutes les spécificités de cette technologie.

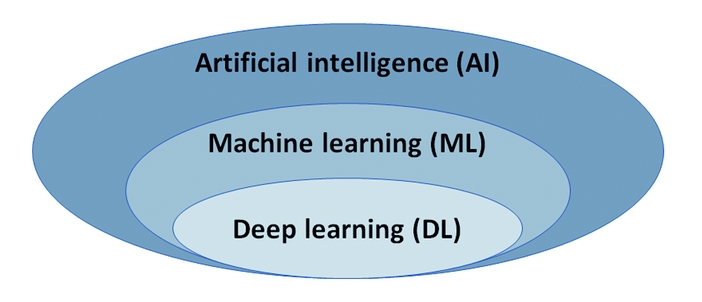

L'intelligence artificielle (IA) s'entend comme un système capable d’imiter les compétences cognitives du cerveau humain. On s’intéresse ici aux systèmes faisant appel à l’apprentissage automatique, dits "AI/ML" (Artificial intelligence/Machine learning), et plus particulièrement aux systèmes à apprentissage profond (Deep learning) basés sur des structures de réseaux neuronaux multicouches nécessitant de grandes quantités de données d’apprentissage.

On notera qu'il faut différencier les algorithmes d’apprentissage verrouillés des algorithmes d’apprentissage adaptatifs (ou continus).

Les éléments clés d’un système AI/ML sont les suivants :

- les tâches (régression, classification, clustering, détection d'anomalie, réduction de dimensionnalité...)

- les modèles (d'entraînement pour usage courant, d'évaluation, de ré-entrainement...)

- les données (d'entraînement, de validation, de test et de production)

- les outils et techniques (préparation de données, algorithmes, méthodes d'optimisation, métriques d'évaluation).

On distingue trois approches principales d’apprentissage automatique :

- supervisé,

- non supervisé,

- renforcé.

D’autres approches en sont dérivées : semi-supervisé, autosupervisé, et par transfert.

Contexte réglementaire et normatif

Le TEAM-NB, l’IMDRF, la FDA américaine, Santé Canada, la FDA taiwanaise et le TGA australien ont édité des recommandations, des lignes directrices ou des guides de bonnes pratiques sur le sujet. Du côté de l'UE, les états membres ont publié en 2021 un projet Artificial Intelligent Act qui établit des règles communes sur l’IA et modifie certains actes législatifs de l’UE.

Enfin, l’IEC et l’ISO publient régulièrement des guides ou "technical reports" destinés aux concepteurs sur des sujets tels que les architectures de référence des mégadonnées, les problèmes de biais dans l’aide à la décision, l’évaluation de la robustesse d’un réseau neuronal, les aspects éthiques et sociétaux, les approches computationnelles, la gouvernance, et dernièrement les concepts et le vocabulaire.

Néanmoins, ces documents ne permettent pas de répondre aux exigences générales de sécurité et de performances requises par les règlements (UE) 2017/745 et 2017/746 sur les DM et DMDIV.

En l’absence de normes harmonisées européennes spécifiques à l’IA, tous ces textes constituent l’état de l’art du domaine, mais ils ne se substituent pas aux normes harmonisées relatives aux dispositifs électro-médicaux programmables et aux logiciels médicaux "classiques" qui restent pleinement applicables (ISO 14971, EN/ IEC 60601-1, EN/ IEC 62304 ou EN/IEC 82304-1, EN/ IEC 62366-1).

Notons que la maintenance, la cybersécurité, le traitement des données personnelles et la surveillance après commercialisation concernent aussi l’IA/ML et font l’objet d’une littérature abondante.

Une problématique réglementaire spécifique à l’AI/ML

La nature de "boîte noire" de l’IA/ML complexifie sa vérification, sa validation, sa certification et sa modification.

Les algorithmes verrouillés ne peuvent absolument pas être traités de la même façon que les algorithmes adaptatifs, où de nouvelles données viennent compléter l’apprentissage tout au long de la vie du système.

Le choix entre "verrouillé" ou "adaptatif" est un choix stratégique qui doit s’appuyer sur l’analyse de risque continue pour valider les performances et donner confiance aux organismes. En tout cas, la qualité des données et l’absence de biais sont des facteurs clés dans la validation du système.

Concernant la "certifiabilité" des systèmes AI/ML par des organismes tiers, tout un référentiel est à construire et à harmoniser.

Une première approche consiste à se focaliser sur le respect de bonnes pratiques d’apprentissage automatique et du système qualité. Une autre approche est de s’appuyer sur un protocole d’évaluation fonctionnelle et quantitative associant des expérimentations reproductibles et des mesures répétables des performances.

Perspectives

Les concepts de l’AI/ML étant maintenant cadrés au travers d’une littérature abondante et internationale, de nouvelles exigences en termes de maîtrise des changements, de maîtrise des risques, d’évaluation de la conformité et de certification des dispositifs médicaux incluant de l’IA/ML doivent être définies. Cela doit se faire en tenant compte des différents types d’algorithmes et de risques associés aux systèmes d’IA.

En attendant des normes harmonisées, les collaborations entre associations d’organismes doivent s’intensifier sur ces sujets. On notera d'ailleurs que le sous-comité technique ISO/IEC JTC1/SC42 est à la manœuvre sur la normalisation de l’IA.

[Source des illustrations : Emitech]

X (ex Twitter)

X (ex Twitter) LinkedIn

LinkedIn